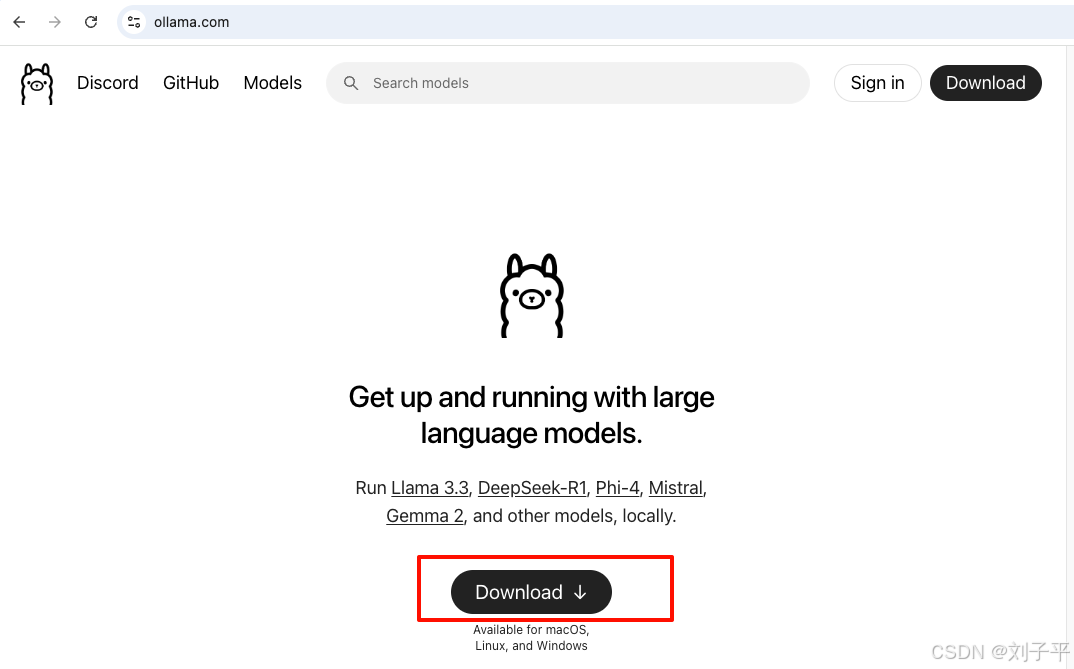

下载安装ollama

地址: https://ollama.com/Ollama 是一个开源的大型语言模型(LLM)本地运行框架,旨在简化大模型的部署和管理流程,使开发者、研究人员及爱好者能够高效地在本地环境中实验和集成最新模型

一路下一步

安装好后

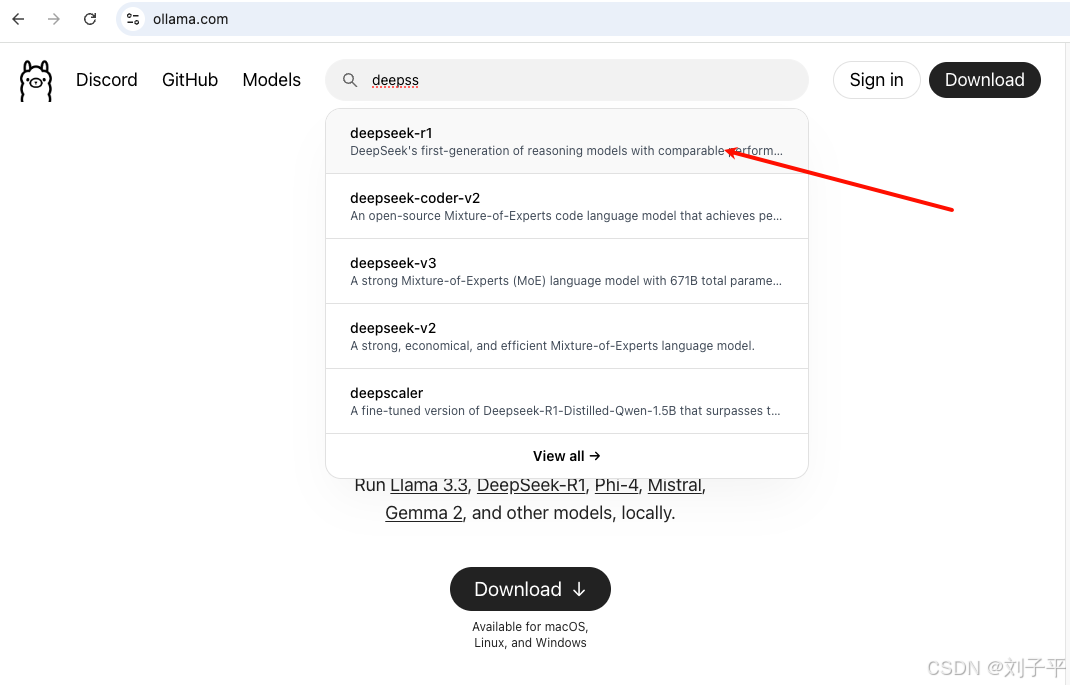

搜索需要的大模型

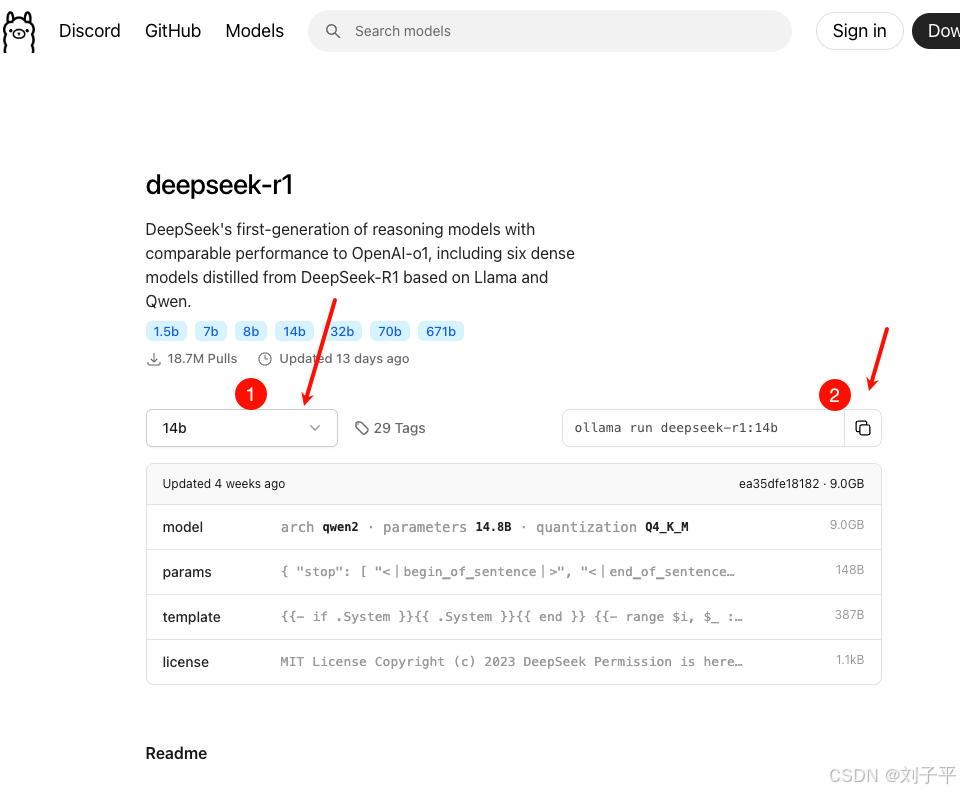

2. 根据自己需求, 选择合适的大模型版本

3. 本地电脑配置较差,我安装的14b

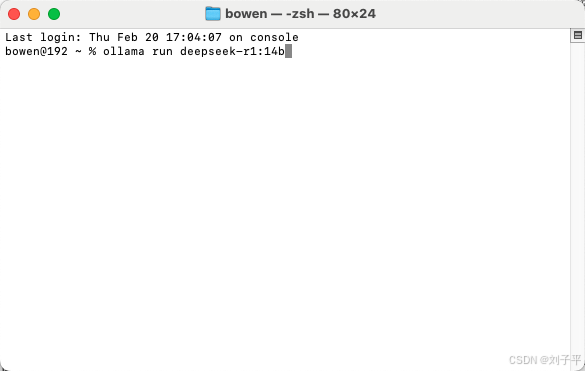

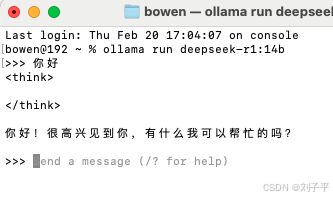

4. 复制命令 ollama run deepseek-r1:14b 到终端运行

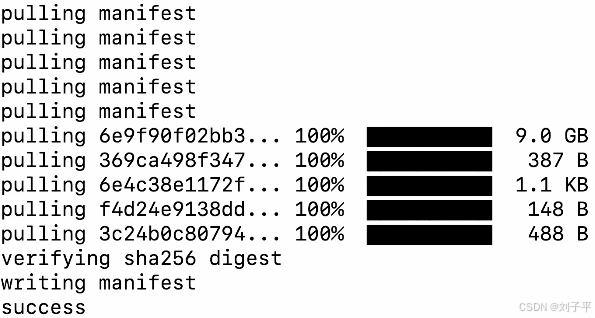

看到 success就成功了

可以开始对话了 (首次较慢)

进阶

不想用黑窗口的话 可以下载cherry Studio

Cherry Studio 是一款开源的多模型 AI 桌面客户端,专为专业用户设计,支持跨平台操作(Windows/macOS/Linux),集成 300+ 大语言模型和本地化部署能力,旨在简化 AI 技术的应用流程,提升工作效率

简单配置就能使用了。